小炒湯圓 投稿

量子位 | 公眾號 qbitai

混合專家(moe)架構已支持多模態大模型,開發者終於不用卷參數量了!

北大聯合中山大學、騰訊等機構推出的新模型moe-llava,登上了github熱榜。

它僅有3b激活參數,表現卻已和7b稠密模型持平,甚至部分指標比13b的模型還要好。

從一張圖表中,moe-llava可以精準分析之中的細節,連線條的顏色都能把控到位。

推理能力也十分優秀,能夠根據照片場景針對性地給出旅行建議。

在物體幻覺基準測試中,moe-llava取得了近87分的成績,超過了一眾13b模型,佔據了成為成績-參數量圖線左上角的位置。

性能方面,在8塊v100上,僅需兩天時間就能完成moe-llava的訓練。

與簡單粗暴地提高參數量相比,moe架構大幅降低了多模態模型的訓練和推理成本。

目前,研究團隊已經開放了所有的數據、代碼和模型,那麼它的表現到底如何呢?

成績不輸13b稠密模型

在圖像問答數據集和benchmark工具上,moe-llava都取得了優異的測試成績。

與前sota方法llava-1.5相比,moe-llava-2.7b×4展現了強大的圖片理解能力,在5個數據集上的表現非常接近llava-1.5。

其中,在sqa數據集上,moe-llava的成績比llava-1.5-7b還要領先1.9個百分點。

而相比於小規模多模態模型tinygpt-v,moe-llava-1.8b×4在相當的激活參數下,在gqa和viswiz數據集中分別超出27.5和10個百分點,說明了moe-llava擁有強大的視覺理解能力。

為了更全面的驗證moe-llava的多模態理解能力,研究團隊在4個benchmark工具包上評估了它的性能。

benchmark工具包中的答案通常是開放性的,而且沒有固定模板,目的是驗證模型能否能完成自然語言問答任務。

結果,moe-llava-1.8b×4超過了圖片分辨率更高的qwen-vl,說明moe-llava這一稀疏模型可以用更少的激活參數達到和稠密模型相當甚至更好的性能。

此外,研究團隊還採用pope工具評估了驗證moe-llava的幻覺,結果它表現最好的性能,意味着它能準確辨別圖像內容。

具體來說,moe-llava-1.8b×4以2.2b的激活參數量,超過了13b的llava-1.5。

另外,moe-llava的yes ratio佔比處於較均衡狀態,說明它能夠根據問題做出正確的反饋。

那麼,moe-llava具體是如何實現的呢?

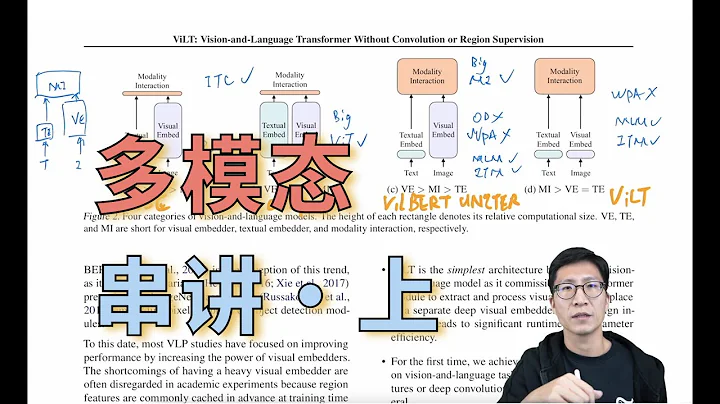

向多模態模型中引入moe架構

moe-llava採用三階段的訓練策略,整體工作流程如下圖所示。

前兩個階段中,圖像和文本信息分別被視覺編碼器(ve)和文本嵌入層(wel)轉化為token。

具體來看,階段1的目標是把視覺token轉換成llm能理解的形式。

為了實現這一點,研究團隊採用一個多層感知機(mlp)將視覺token投影到llm的輸入域,使其作為llm能理解的偽文本token。

在這個階段,llm被訓練學會描述圖片,為理解更高層次的圖片語義的打下基礎。

階段2是用多模態的指令數據來對llm進行微調,使之成為有多模態理解能力的模型。

這個階段的指令更加複雜,包含圖片邏輯推理、文字識別等高級任務,對模型的多模態理解能力有了更高的要求。

通常來說,如果是稠密多模態模型,訓練過程到此就完成了,但研究團隊發現同時將llm多模態化和稀疏化是有一定困難的。

為了解決這個問題,研究團隊把該階段的權重作為階段3的初始化依據,以降低稀疏模型學習的難度。

作為初始化,研究團隊把前饋神經網絡(ffn)複製多份,作為專家集合的初始化權重。

當視覺token和文本token被送入moe架構時,router會計算每一個token和專家們的匹配權重,然後被送入最匹配的top-k個專家進行處理,最後根據router的權重加權求和匯聚成輸出。

當top-k個專家被激活時,其餘的專家保持靜默,這種模型構成了具有無限可能的稀疏通路的moe-llava。

整體上,在scienceqa數據集上訓練時,所有的moe layer中的專家的負載比較平衡。

然而隨着模型逐漸被稀疏化,第17到27層的專家的負載突然增大,甚至幾乎包攬了所有tokens。

對於淺層的5-11層,主要是由專家2、3、4共同協作。值得關注的是,專家1幾乎只在第1-3層工作,隨着模型變深,專家1逐漸退出了工作。

可以看出,moe-llava的專家們學到了某種特定的模式,它能夠按照一定的規律進行專家們的分工。

進一步地,研究團隊還分析了不同專家的模態分佈,發現文本和圖像的專家分佈極其相似。

例如,當專家3在17-27層工作時,它所處理的文本和圖像的佔比是相似的,這展現出moe-llava中的專家對於模態並無明顯的偏好。

同時,研究團隊還在token層次上觀察了專家們的行為,跟蹤了所有token在稀疏網絡中的軌跡在下游任務。

通過pca降維方式,研究團隊分析了對文本和圖像所有的激活的通路,得到了主要的10條通路。

團隊還發現,對於某個未見的文本或圖像token,moe-llava始終偏向於派發專家2和3來處理;專家1、4則傾向於處理初始化的token。

作者簡介

moe-llava由北大深研院信息工程學院袁粒課題組主導,該課題組主要研究機器視覺、機器學習和腦科學。

去年推出的法律大模型chatlaw和ai表格工具酷表(chatexcel),該課題組都有參與其中。

本文第一作者是該實驗室的碩士生林彬,此前他還以一作或共同一作的身份參與過和多模態對齊框架languagebind(入選iclr 2024)、視頻大模型video-llava等工作。

此外,來自中山大學、騰訊、farreel ai lab、鵬城實驗室等機構的研究人員也參與了本項目。

github:

https://github.com/pku-yuangroup/moe-llava

論文地址:

https://arxiv.org/abs/2401.15947

demo:

https://huggingface.co/spaces/languagebind/moe-llava